El fenómeno conocido como ‘colapso del modelo’ está sumándose al creciente escepticismo sobre la trayectoria a largo plazo de la inteligencia artificial.

Esto ocurre justo cuando Wall Street comienza a cuestionar si las enormes inversiones de las grandes tecnológicas en el desarrollo de la IA finalmente rendirán frutos.

Los chatbots de IA como ChatGPT operan con grandes modelos de lenguaje, entrenados con una cantidad casi inconcebible de datos (billones de palabras en algunos casos) extraídos de páginas web, artículos, secciones de comentarios y más.

Con estos vastos conjuntos de datos, las empresas de IA han podido crear productos capaces de generar respuestas sorprendentemente relevantes a las consultas de los usuarios.

Sin embargo, algunos observadores de la IA han expresado su preocupación sobre la posibilidad de que estos modelos resulten ser significativamente menos precisos y ‘colapsen’ si se entrenan con contenido generado por IA en lugar de por humanos reales.

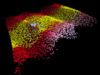

Un artículo de 2023 sobre el colapso de modelos mostró que las imágenes humanas generadas por la IA se distorsionaban cada vez más después de que el modelo se reentrenaba con ‘incluso pequeñas cantidades de su propia creación’.

Los investigadores compararon este fenómeno con un sistema de IA que se ‘envenena’ con su propio trabajo.