DeepMind, de Alphabet, superó la limitación para el aprendizaje automático ante la incapacidad del software para recordar, es decir, el ‘olvido catastrófico‘.

La incapacidad del software para recordar era una limitación clave que afecta a una de las tecnologías más prometedoras de aprendizaje automático.

El descubrimiento, publicado el martes pasado en la revista académica Proceedings de la Academia Nacional de Ciencias, puede abrir el camino para que los sistemas de inteligencia artificial (AI) se apliquen más fácilmente en múltiples tareas, en lugar de ser estrictamente entrenados para un propósito.

También debería mejorar la capacidad de los sistemas de AI para transferir el conocimiento entre las tareas y para dominar una secuencia de pasos vinculados.

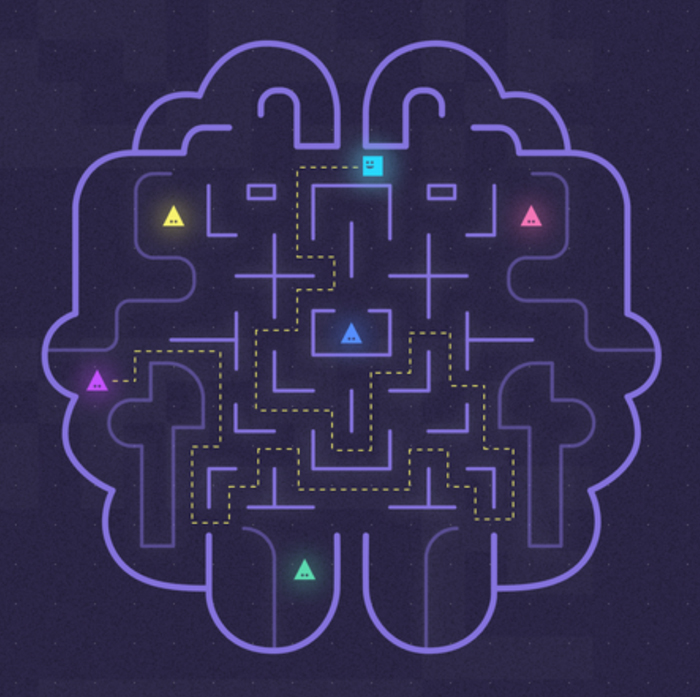

Para la traducción de idiomas, las redes neuronales, que se basan libremente en la estructura de las sinapsis en el cerebro humano, se considera la mejor técnica de aprendizaje automático, la clasificación de imágenes y la generación de las mismas.

Pero estas redes sufren de una falla importante que los científicos llaman ‘olvido catastrófico’. Existen en una especie de presente perpetuo: cada vez que se le dan nuevos datos a la red, sobreescribe lo que ya ha aprendido anteriormente.

Una de las formas en que funciona la memoria es que las conexiones entre las neuronas que parecen importantes para una habilidad particular, se vuelven menos probables de volver a conectarse, según los investigadores de DeepMind que se basaron en esta teoría, conocida como consolidación sináptica, para crear una forma que permita que las redes neuronales recuerden. Trabajaron con Claudia Clopath, una neurocientífica del Imperial College de Londres, que es consultora del documento.

Finalmente los investigadores crearon un algoritmo llamado Elastic Weight Consolidation o EWC, que calcula la importancia de cada conexión en una red neuronal a la tarea que acaba de aprender y asigna a esta conexión un peso matemático proporcional a su importancia. El peso disminuye la velocidad a la que se puede alterar el valor de ese nodo particular en la red neuronal. De esta manera, la red es capaz de retener el conocimiento mientras aprende una nueva tarea.

Los investigadores probaron el algoritmo en 10 juegos clásicos de Atari que la red neuronal tuvo que aprender a jugar desde cero. DeepMind había creado previamente un agente de IA capaz de jugar estos juegos, igual o mejor que cualquier jugador humano. Pero esa IA anterior sólo podía aprender un juego a la vez. Se le mostró más tarde uno de los primeros juegos que aprendió y tuvo que empezar todo de nuevo.

El nuevo software habilitado para EWC fue capaz de aprender todos los 10 juegos y, en promedio, se acerca al nivel humano de rendimiento en todos ellos. Sin embargo, no funcionó tan bien como una red neuronal entrenada específicamente para un solo juego, comentaron los investigadores.

DeepMind, que fue adquirida por Alphabet en 486.4 millones de dólares en 2014, es más conocida por haber creado un software de AI capaz de vencer a los mejores jugadores del mundo en el antiguo juego de estrategia asiático Go. Este logro se consideró un hito importante en la informática porque Go tiene tantos movimientos posibles que una computadora simplemente no puede averiguar el mejor movimiento en cada situación y en su lugar debe confiar en algo más parecido a la intuición, haciendo conjeturas educadas basadas en su propia experiencia.

DeepMind es líder mundial en investigación de inteligencia artificial, que es uno de los avances científicos más importantes en la historia, con un amplio espectro de beneficios potenciales para la humanidad.

Con información de Bloomberg