A pesar de su aparente cercanía y atractivo, los regímenes de tratamiento contra el cáncer desarrollados utilizando herramientas de inteligencia artificial están plagados de errores y es probable que pasen varios años antes de que puedan ser lanzados de manera confiable.

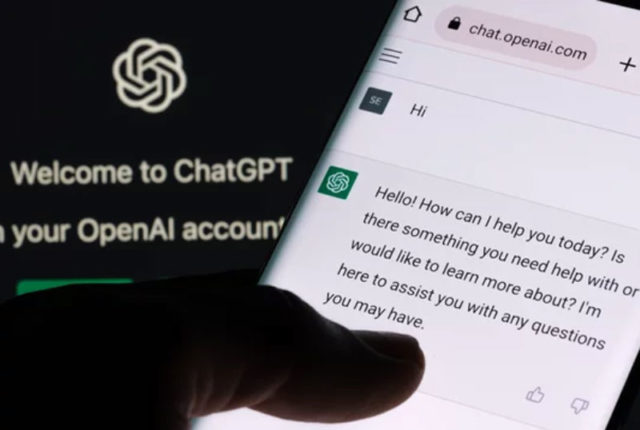

ChatGPT, aunque suele comunicarse de manera confiada y aparentemente lógica, su tendencia a combinar información incorrecta representa un riesgo potencialmente peligroso.

Así lo afirmó Danielle Bitterman, coautora del estudio y oncóloga del programa de Inteligencia Artificial en Medicina de Mass, perteneciente al sistema de salud general de Brigham.

Bitterman señaló que incluso para un experto es difícil discernir cuál recomendación es incorrecta.

Aunque la mayoría de las respuestas generadas por ChatGPT incluyen al menos una recomendación en línea con las pautas establecidas por la red nacional integral del cáncer, los investigadores descubrieron que alrededor de un tercio de estas sugerencias eran inexactas.

Además, aproximadamente el 12% de las respuestas presentaban lo que se denominó como ‘alucinaciones’, es decir, recomendaciones que no tenían ninguna correspondencia en ninguna parte de las directrices médicas, según informaron los investigadores.

OpenAI ha subrayado en repetidas ocasiones que ChatGPT puede ser poco confiable, capaz de generar información ficticia y requiere un manejo cuidadoso, especialmente en contextos donde el riesgo es alto.